LinuxでWebサイトの全ページをダウンロードする方法

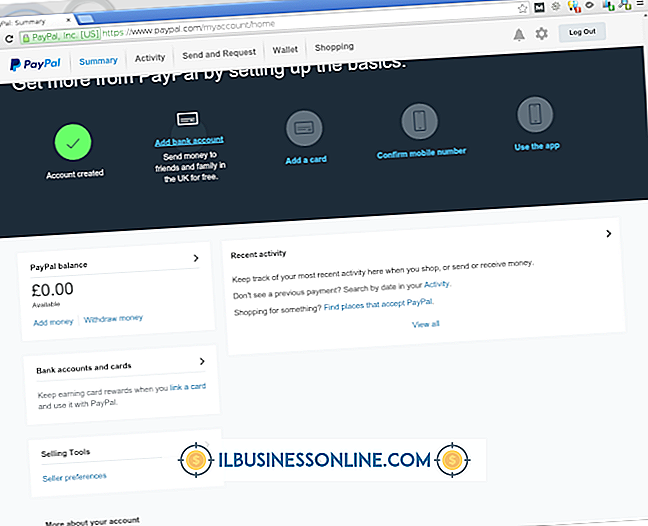

Wgetは、Webサイトからコンテンツをダウンロードするために使用できる、Linux上の強力なオープンソースソフトウェアです。 場合によっては、Webサイト上のすべてのコンテンツのコピーを作成する必要があります。おそらく、サイトのミラーを作成したり、後で使用するために現在のコンテンツを保存したりすることです。 Wgetを使えば、Webサイト全体を1行のコマンドでダウンロードできます。

1。

whichコマンドを使用して、wgetがインストールされていることを確認してください。 ターミナルで "which wget"と入力すると、WgetがLinuxコンピュータにインストールされている場所が表示されます。 Wgetがインストールされていない場合は、YumやApt-getなどのディストリビューションのソフトウェアインストールツールを使用してWgetをインストールしてください。

2。

Webサイトを反映するようにフラグを設定します。 Wgetには、プログラムの動作を変更するために設定できる複数のフラグがあります。 "-m"フラグはWebサイト全体をダウンロードするために使用されます。 たとえば、次のように入力します。

wget -m www.fake-web-site.com

これにより、コンピュータ上に "www.fake-web-site.com"のローカルコピーが作成されます。 デフォルトでは、Wgetはそれが実行されたディレクトリの中にWebサイトと同じ名前のディレクトリを作成します。

3。

ブラウザでページのローカルコピーを開いてコンテンツが取得されたことを確認します。

必要なもの

- wget

警告

- Wgetは、サーバーからコンテンツを要求するときにかなりの量の帯域幅を消費する可能性があります。 また、ファイアウォールによっては、単一のクライアントからの迅速な要求を攻撃として解釈する可能性があり、その結果、IPアドレスが一時的にサーバーからブロックされる可能性があります。 要求間の時間を制限するために-wフラグが設定されていることを確認してください。 例えば:

- wget -m -w 10 www.fake-web-site.com

- Wgetは10秒間待機してからサーバーに次のファイルを要求します。

人気の投稿

Mac OS XのTerminalアプリケーションを使うと、オペレーティングシステムのUNIXシェルにアクセスして、システム環境設定からはアクセスできないコマンドを実行することができます。 「ターミナル」の「ファイルフラグの変更」(chflags)ユーティリティを使用してフォルダまたはファイルを隠すことができます。これにより、Mac OS Xのグラフィカルユーザインタフェースには表示されなくなります。 隠しフラグをフォルダに割り当てると、FinderやMacBookの他のアプリケーションには表示されなくなります。 1。 ターミナルを開きます。 2。 引用符なしでターミナルに「chflags hidden」と入力します。 3。 フォルダのパスを入力するか、フォルダを「Finder」から「ターミナル」ウインドウにドラッグアンドドロップします。 たとえば、「Documents」フォルダを非表示にするには、「chflags hidden〜/ Documents」と入力します。 4。 「Return」キーを押してコマンドを実行してください。 5。 ターミナルウィンドウを閉じます。

続きを読みます

信頼できるビジネスメッセージを書くための最善の方法は、あなたが伝える情報と態度についてできるだけ正直になることです。 ビジネスメッセージは、顧客と従業員に、自分の会社とは違うものであることを説得するためのマーケティングツールとして機能するのではなく、会社にすでに存在するオリエンテーションを明確にして集中させるのに役立ちます。 あなたの価値観と理念を一貫して表現するようにそれを構築するためにあなたが最初にあなたの会社を始めたときあなたはあなたのビジネスメッセージを理解するべきです。 1。 会社の焦点を顧客に伝えることを目的としているのか、それとも従業員をやる気にさせ指導するために使用するのかなど、ビジネスメッセージの目的を定義します。 特定の目標を達成するためにビジネスメッセージを作成することはおそらくあるでしょうが、それはまたあなたのビジネスがそのオペレーションのあらゆる面で例証するであろう理想と原則を表現するべきです。 例えば、従業員の幸福に捧げられた事業はまた、その製品とサービスがその顧客の幸福に与える影響についても深く意識しているべきです。 2。 平凡な人が理解できる言葉や概念を使って、シンプルで誠実な言葉でビジネスメッセージを表現しましょう。 従業員や顧客の生活の質を向上させることへのコミットメント、または従業員が創造的に成長できる職場環境を設計したいという望みなど、会社の無

続きを読みます

慈善団体や必要としている個人にお金を寄付することは、あなたのビジネスが社会的責任を実践するための良い方法です。 あなたのビジネスのブランドを使って、あなたが強く感じている慈善団体への寄付を募ることができます。 あなたのビジネスが慈善団体に関わっているという事実はあなたの顧客がその慈善団体にお金を寄付するように励ますかもしれません。 寄付口座を開設すると、寄付のプロセスが簡単になり、寄付プロセスの管理に役立ちます。 1。 あなたのビジネスで寄付口座を管理する人を選んでください。 この人は、口座を監視し、必要に応じて慈善団体の受取人に資金を支払う責任があります。 彼はまた資金の取り扱いに関する正確な記録を保持する責任があります。 2。 寄付口座を開設するために銀行に持っていく必要がある情報を整理します。 例えば、銀行はあなたの事業免許、身分証明書および現在の銀行情報を見ることを要求するかもしれません。 3。 あなたが寄付口座を開設したい銀行に行きます。 慈善団体への寄付を受け付けるための口座開設について銀行の担当者に相談してください。 担当者は、人々がアカウントにお金を寄付することができるさまざまな方法など、利用可能なオプションについて調べます。 担当者は、あなたと一緒にオプションを調べた後に、あなたが完了するための申請書を提示します。 4。 申込書に記入して寄付口座を開きます。 慈善団

続きを読みます

事件への迅速かつ適切な対応は、あなたのビジネスが緊急事態が本格的な危機になるのを防ぐのに役立ちます。 ストレスの時には、あなたのスタッフはあなたのビジネスを害する声明をパニックにするか、またはするかもしれません。 包括的なインシデントアクションプランを設計し、実行することで、明確で具体的なポリシーを確立することができます。また、従業員がインシデントに対する対応を事前に練習できるようにすることもできます。 インシデントを定義する 明確に定義された規則、文書化された行動計画、そして明確な指揮系統を持つことは、潜在的な広報の悪夢に直面しているあなたの組織に力を与えます。 組織内の管理者は、インシデントを構成する要素について異なる理解を持っている可能性があります。 対応計画でインシデントを明確に定義し、それらを分類するにはインシデントが多すぎる場合は、代わりにインシデントの特性をリストしてみてください。 たとえば、あなたの会社をマイナスの宣伝にさらす、予算内にある金額よりも会社に多額の費用がかかる、または会社の秘密が露呈するような事件として何かを定義することができます。 報告義務 インシデントを適切に管理するには、適切なマネージャにただちに通知されるようにする必要があります。 各タイプのインシデントの処理を担当するマネージャに明確に注意を払い、危機に対処するための指揮命令系統の概要を説明しま

続きを読みます

重要な調査によると、職場の多様性を促進することには多くの利点があります。 ますます多元的な社会では、それは正しいことのように思えるかもしれません。 しかし、利他主義を超えて、職場の多様性もあなたの収益に役立ちます。 公開企業に関する2015年の報告によると、最も多様な組織は35%収益性が高いと見られています。 両方をうまくやろうとするなら、多様化する時が来ました。 これを始める方法についての実用的で楽しいアイデアがいくつかあります: 多様性をあなたの使命の一部にする ほとんどの企業と同様に、あなたはおそらくあなたが人の性別、人種、身体障害、民族、宗教、年齢、その他の人口統計上の考慮に基づいて差別されない機会均等雇用者であることを求人掲載に注意します。 しかし、それは法律を順守することと、多様性とその目標を所有することの2つです。 あなたの会社の使命声明に多様性とあなたがそれを達成するためにあなたがとる必要がある対策の本当の目標を加えなさい。 昇進トレーニングを提供する あなたは男性が資格の60%しか満たしていないのに女性は100%を満たしているように見えるときに仕事に応募する傾向があることをご存知ですか? ジェンダーの不平等と闘うためには、候補者が彼らの新しい役割で何を達成すると期待されるかに焦点を当てた職務明細書を書いてください。 そしてあなたのすべての従業員のために、彼らが会社の

続きを読みます