Robots.Txtを使用してサブドメインをブロックする方法

Webサイトは、あなたの中小企業を宣伝するだけでなく、あなたの製品とユニークな資格を紹介するのに良い方法です。 大規模なWebサイトを管理している場合は、おそらくいくつかのサブドメインを使用し、各サブドメインにはWebホスト上に独自のフォルダがあります。 検索エンジンのクローラが特定のサブドメインを解析してインデックスを付けたくない場合は、robots.txtファイルを使用してそれらをブロックできます。

1。

画面の左下隅にある[スタート]ボタンをクリックします。

2。

[スタート]メニューの下部にある[検索]ボックスに「メモ帳」と入力します。

3。

[スタート]メニューの上部にある[プログラム]セクションの[メモ帳]をクリックしてメモ帳を起動します。 新しい文書が自動的にメモ帳に作成されます。

4。

これら2行をメモ帳文書に挿入して、すべてのロボットがサブドメインを解析できないようにします。

ユーザーエージェント:*許可しない:/

5。

"Ctrl-S"を押して "名前を付けて保存"ウィンドウを開きます。

6。

[ファイル名]ボックスに「robots.txt」と入力し、ファイルを保存するフォルダを選択して[保存]をクリックして保存します。

7。

保存したrobots.txtファイルを、検索エンジンのクローラから保護する各ドメインのルートディレクトリにアップロードします。 ルートディレクトリは最上位ディレクトリです。

先端

- あなたはどんなFTPクライアントソフトウェアあるいはあなたのホストのWebファイルマネージャを使ってもファイルをアップロードすることができます。

人気の投稿

包括的な従業員ハンドブックは、今日のビジネス界では不可欠です。 ハンドブックが存在するため、雇用主は職場を効果的に管理できます。 ハンドブックを配布することで、従業員は自らの責任を認識し、職務を効果的に遂行することができます。 従業員ハンドブックは、全従業員の期待を文書化することによって職業環境を維持するのに役立ちます。 関数 従業員ハンドブックは、会社の業務手順書を含む文書です。 それは私たちが通常雇用の初日に労働者に届けたことです。 雇用主は、職場で期待される重要な方針を確立し、雇用主と従業員の権利を保護するために、従業員ハンドブックを利用します。 この文書は、職場での嫌がらせ方針を含む会社の雇用機会均等方針や職場における安全への期待などの法的情報を開示しています。 利点 従業員ハンドブックにはいくつかの利点があります。 この本は、職場のやるべきこととしないことを概説することで、組織がより円滑に運営できるように支援します。 労働者は彼らに何が期待されているのか理解しているので、それは従業員の説明責任を促進し、安定した仕事のパフォーマンスを維持します。 また、従業員ハンドブックには懲戒手続きが説明されているため、業績管理がより簡単になります。 HRマガジンの記事によると、しかし、単にマニュアルに犯罪のリストを持っているだけでは十分ではありません。 雇用者は、ハンドブックの規則を一貫

続きを読みます

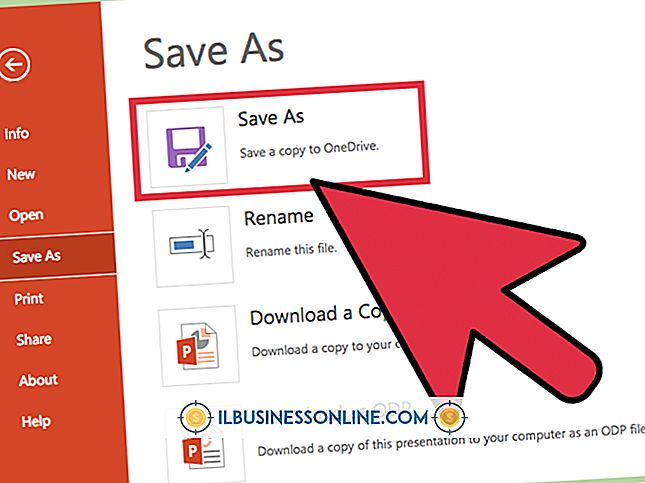

ビジネススライドは単なるプレゼンテーション以外にも使用できます。 それらをオンラインで共有して新しい顧客を引き付け、あなたの製品やサービスに興味を持たせることができます。 特定のトピックに関するあなたの専門知識を実証するためにも使用できます。 中小企業の所有者がビジネススライドをオンラインで幅広い聴衆に共有できるようにする無料サービスがいくつかあります。 Webサイトを介した共有 ビジネススライドのプレゼンテーションを自分のWebサイトまたは複数のスライド共有Webサイトで共有して、より幅広いユーザーにアピールすることができます。 あなた自身のウェブサイトであなたのプレゼンテーションを共有することはあなたの顧客にとって特定の分野でのあなたの専門知識を強調します。 スライド共有Webサイトでプレゼンテーションを共有すると、新規顧客に連絡するのに役立ちます。 多くの人気のあるスライド共有サイトには、何百万もの登録ユーザーがいます。 これらのユーザーはあなたのプレゼンテーションを読んだり、おそらく彼ら自身の研究でそれを引用するかもしれません。 ソーシャルメディア ソーシャルメディアを使用すると、ビジネスのスライドをフォロワー、友達、オンラインのつながりと共有できます。 プレゼンテーションをWebサイトまたはスライド共有WebサイトでホストしてURLを生成し、それをソーシャルネットワークアカ

続きを読みます

Windows Media Player 12を使用すると、コンピュータを完全なエンターテイメントセンターに変えることができます。 また、ビデオを見たり、ビジネスに必要なプレゼンテーションを実行することもできます。 ときどき、Windows Media Playerの動作が遅くなったり、メディアの再生が完全に停止したりすることがあります。 この場合、1つの解決策はWindows Media Playerをアンインストールして再インストールすることです。 ただし、標準のWindowsアンインストールプロセスを使用することはできません。WindowsMedia Playerをアンインストールして再インストールするには、Windowsの機能ダイアログを使用する必要があります。 1。 [スタート]をクリックして、検索フィールドに「windows features」と入力します。 次に「Enter」を押してWindowsの機能ダイアログを開きます。 2。 [Windows Media Player]の横のチェックを外して、Windows Media Playerを無効にする(またはアンインストールする)ことを確認します。 3。 「今すぐ再起動」をクリックしてコンピュータをシャットダウンし、もう一度起動します。 4。 [スタート]ボタンをクリックし、検索フィールドに「windows featur

続きを読みます

小さなビジネスマンや女性は皆、痛みを伴う真実を知っています。お金を稼ぐにはお金を使わなければなりません。 労務費、設備費、消耗品費、またはその他の事業の目的にかかわらず、すでに使用された資金は、経費が回収できない場合、回収費用と呼ばれます。 経済理論では、沈められたコストは将来の購買決定に影響を及ぼさないはずです。 しかし、人間の心理学とは何か、つまり沈んだ費用が私たちの次の動きに影響を与えることもあります。 ビジネスでも日常生活でも、沈んだコストの例1〜2は、沈んだコスト効果の心理学を説明するための最良の方法です。 先端 サンクコスト - 定義:行われたが回収できない費用。 費用の種類としてのサンク費用 来月の給与計算や年間購読料の支払いなど、一部の費用が予想されます。 その他の費用は回収可能です。 たとえば、100パーセントの返金保証が付いているオフィス機器を購入しても、満足していない場合は購入できます。 これは回収可能費用です。 お金はすでに使われていますが、それは回収できません。 いくつかの沈没費用は正確に述べることができます。 例えば、先月の給与は、回収される選択肢がない、すでに使われたお金です。 その他の費用は現実的ですが、正確にはわかりません。 あなたがあなたの会社のためにトラックを買うならば、あなたがそのトラックを売ることに決めたとき、トラックに費やされたお金のいくら

続きを読みます

何十、さらには何百もの応募者と面会した後で、あなたの採用決定を絞り込むのは難しいかもしれません。 「起業家」のPaul Sarvadiによって示唆されているように、雇用前評価を提供することによって潜在的な従業員を排除しました。 米国雇用機会均等委員会(EEOC)によって概説されているように見込み客を差別しない限り、これは適切な従業員を見つけるための効果的な方法です。 テストを実施する前に、筆記または口頭による評価方法を選択してください。 ドキュメンテーション 文書化は、評価後に採用されなかった見込みに基づく差別による訴訟のリスクを減らすのに役立ちます。 EEOCは、就職前テストで人種、宗教、性別などの側面を区別することを許可していないため、差別が問題の要因ではないことを証明するために評価を文書化します。 文書化された評価は、テストのコピーを人事担当のファイルに保存することで文書化するのが簡単です。 口頭テストは文書化するのが難しいです。 問題が心配な場合は、万が一のためにテストを記録し、オーディオファイルを保存することを検討してください。 標準化された質問 雇用前評価では、すべての申請者に対して標準化された質問が必要です。 テストが書かれるとき、あなたの会社で仕事を望んでいるすべての人に同じ質問のシートを提供してください。 面接担当者が毎回同じ質問をするとは限らないため、テストが口頭

続きを読みます